Pour qu’un LLM (Large Language Model) apporte une vraie valeur business, il doit sortir de l’interface de “chat” pour entrer dans la chaîne de production. Il doit être capable de traiter non pas une requête, mais des millions de lignes, de manière fiable, sécurisée et automatisée.

C’est exactement l’objectif de la nouvelle mise à jour d’Anatella (version 4.06) : transformer l’IA générative en une brique ETL industrielle comme une autre.

Voici ce que cela change concrètement pour vos flux de données.

1. La Souveraineté avant tout : Cloud ou Local, vous avez le choix

Le premier frein à l’adoption de l’IA en entreprise est la sécurité. Envoyer vos données clients ou des documents confidentiels vers les serveurs américains d’OpenAI est souvent inenvisageable.

Anatella brise cette barrière en offrant une approche hybride :

- Mode Remote (Cloud) : Connectez-vous aux APIs standards (OpenAI, etc.) pour des tests rapides ou des données publiques.

- Mode Local (On-Premise) : C’est la grande force de cette update. Vous pouvez exécuter des modèles Open Source (GPT, Llama, Mistral, Gemma, etc.) directement sur votre infrastructure via l’intégration native de Llama.cpp.

Le bénéfice pour vous ? Vos données ne quittent jamais votre serveur (Souveraineté totale). De plus, en utilisant votre propre GPU/CPU, vous éliminez les coûts variables liés aux appels API.

2. Du “Blabla” à la Donnée Structurée (L’industrialisation)

Le problème des LLM, c’est qu’ils sont bavards. Dans un processus ETL, vous n’avez pas besoin de politesses, vous avez besoin de JSON propre.

Anatella intègre désormais deux leviers pour “dompter” l’IA :

- Le System Prompt : Pour donner des directives strictes au modèle (ex : “Tu es un extracteur de données, ne réponds qu’en JSON”).

- Le Schéma JSON : Vous définissez une grammaire stricte. Le LLM est forcé de répondre selon ce format (ex: un objet contenant “Nom”, “Montant”, “Date”). Si la sortie ne correspond pas au schéma, elle est rejetée.

Le bénéfice pour vous ? Vous transformez du texte libre (emails, PDFs, commentaires) en tableaux structurés exploitables immédiatement par les boîtes suivantes de votre graphe.

3. Cas d’usages : Que pouvez-vous automatiser dès aujourd’hui ?

Cette nouvelle “boîte” ouvre la porte à des scénarios auparavant très complexes à coder :

- Intelligent Document Processing (IDP) : Passez le contenu d’un fichier (PDF, contrat) en “pièce jointe” (attachment) à votre prompt. Le LLM peut alors analyser le document pour en extraire des informations précises comme des IBANs ou des clauses spécifiques.

- Nettoyage de données contextuel : Utilisez l’IA pour normaliser des adresses mal formatées, déduire le genre d’après un prénom, ou catégoriser des produits.

- Génération de données synthétiques : Créez des jeux de données de test réalistes pour vos environnements de dev.

4. Pour les Experts : Scripting JS et Boucles de Contrôle

Pour les cas simples, le Mode Simplifié suffit : une colonne en entrée (Prompt), une colonne en sortie (Réponse).

Mais pour les ingénieurs Data, le Mode Script JS offre un contrôle total. Vous pouvez coder en JavaScript pour interagir finement avec le modèle :

- Boucles de validation : Demandez au LLM son niveau de confiance. Si la confiance est faible, scriptez une boucle pour reformuler la question et réinterroger le modèle automatiquement.

- Mémoire gérée : Manipulez le contexte (les échanges précédents) pour créer des conversations suivies sur plusieurs itérations.

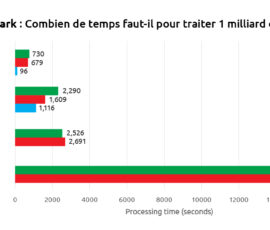

5. Performance : L’efficience TIMi appliquée à l’IA

Faire tourner des modèles d’IA en local consomme de la mémoire vidéo (VRAM). Fidèle à sa philosophie d’optimisation, Anatella gère intelligemment les ressources serveurs :

- Gestion Automatique : Le serveur “Llama.exe” démarre quand on en a besoin et s’arrête pour libérer la mémoire.

- Exploitation CPU & GPU : Pas de GPU ? Pas de problème. Pour les modèles légers (< 5 milliards de paramètres), le processeur (CPU) suffit amplement. La carte graphique devient un accélérateur de confort, pas un prérequis bloquant.

- Quantization supportée : Anatella exploite les formats compressés (Q4 ou Q6). Cela permet de faire tourner des modèles massifs et très performants sur une simple carte graphique grand public (à 500€), en optimisant drastiquement l’empreinte mémoire.

Conclusion

L’IA Générative n’est plus une magie réservée aux Data Scientists parlant Python. Avec cette mise à jour, elle devient une composante robuste de votre arsenal ETL. Que ce soit pour résumer, extraire ou générer, vous pouvez désormais le faire à l’échelle, en toute sécurité.

Pour aller plus loin, cette nouvelle fonctionnalité est documentée en détail dans la section 5.9.12 du AnatellaQuickGuide.pdf. Nous vous recommandons également la lecture de la section 5.1.8, qui regorge d’informations pertinentes pour utiliser les LLM avec efficience.

Envie de tester ? La fonctionnalité inclut une installation automatisée des composants requis. Téléchargez la dernière version d’Anatella et lancez votre premier modèle local en quelques clics.