Data wrangling: definitie, stappen, tools

De technische term “Data wrangling”, ook wel “Data munging” genoemd, lijkt op het eerste gezicht intimiderend. De bedoeling van dit artikel is om het woord te demystifiëren.

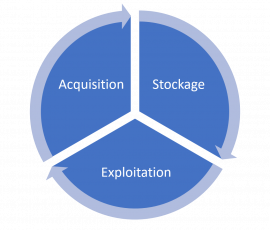

Data wrangling wordt gedefinieerd als een belangrijk onderdeel van een groter proces dat “gegevensvoorbereiding” heet. Data wrangling is the process performed to collect, select, re-structure, enrich and ultimately transform information with the aim of answering a specific question. This overarching question is usually highly analytical.

Data wrangling chews up a considerable amount of time. For example, it’s a well-known fact that data scientist are spending much of their time in data preparation activities (more than 80% of their time, actually) and a large part of these data preparation activities is focused on“Data wrangling”.

Summary

- Data wrangling in het kort

- Waarom gegevensverwerking zo belangrijk is

- Stappen van data wrangling

- Uitdagingen van data wrangling

- Technieken en hulpmiddelen

- Is het al die moeite waard?

A Brief Explanation of Data Wrangling

Data wrangling is het proces waarbij ruwe gegevens worden omgezet om ze klaar te maken voor verdere analyse door data wranglers, ook wel mungers genoemd. Dit betekent dat gegevensverwerking het werk is dat op de gegevens wordt verricht voordat zij via verdere analyse worden uitgesplitst. De gegevensverwerking houdt in dat de kwaliteit van de gegevens wordt beoordeeld op basis van de context en dat de gegevens worden omgezet in het formaat dat nodig is voor verdere analyse.

Als u zich afvraagt of het data wrangling echt nodig is, beschouw het proces dan als het leggen van de fundering voor een huis.

Waarom is gegevensverwerking zo belangrijk?

Gegevensverwerking genereert gestructureerde informatie die gebruikt kan worden bij analytische activiteiten:

- Maken van een analytische basistabel (ABT)

- Analyse van chronologische reeksen

- Opstellen van kritieke prestatie-indicatoren (KPI’s)

- Creatie van dashboards (Business Intelligence)

- Creatie van voorspellende modellen

Het genereren van dergelijke gestructureerde gegevensreeksen is een uitdaging op zich. Maar door de nodige tijd te investeren in een nauwgezette en volledige gegevensverwerking wordt de solide basis gelegd die nodig is om zinvolle analytische taken uit te voeren.

Stappen in data wrangling

Door de gegevens stroomopwaarts te verwerken verloopt de analyse (stroomafwaarts) sneller en efficiënter. Hoewel de verwerking van de gegevens vervelend is, is het zeker de moeite waard.

De gegevensverwerking begint met een ontdekkingsfase, waarin u zich vertrouwd kunt maken met de gegevens. Het structureren van de gegevens volgt uiteraard op het verzamelen van de ruwe gegevens. Omdat er bij deze gegevens structuur ontbreekt, moeten zij geherstructureerd worden volgens het door het bedrijf gekozen analytische model.

De volgende stap is het opschonen van de gegevens, wat bestaat uit het “corrigeren” van de ruwe gegevens voordat ze naar de volgende stap gaan. Bij het opschonen ligt de nadruk op het verwerken van uitschieters, correcties en het verwijderen van slechte gegevens.

Vervolgens komt de verrijking van de gegevens. Dit is de gelegenheid om de gegevens te “vergroten”, ze aan te vullen om aan de behoeften van het bedrijf te voldoen

Zodra de gegevens verrijkt zijn, is het tijd om ze te valideren. Door de gegevens te valideren kunnen potentiële kwaliteitsproblemen aan het licht worden gebracht, zodat ze zo nodig kunnen worden aangepakt en behandeld. De gemakkelijkste en snelste manier om uw gegevens te valideren is het gebruik van een tool voor automatische modellering: tijdens bijna alle activiteiten op het gebied van voorspellende modellen komen eventuele inconsistenties in de gegevens immers direct aan de oppervlakte, en het is dan gemakkelijk en ongecompliceerd om ze stroomopwaarts te corrigeren. Met een tool voor automatische modellering kunt u al uw TBA’s valideren met een paar muisklikken.

De uitdagingen van data wrangling

Wanneer u aan data wrangling doet, manipuleert u uw gegevens met als hoofddoel een specifieke vraag in verband met uw bedrijf te beantwoorden. Dit betekent dat de transformatie die op uw gegevens wordt toegepast, zal worden bepaald door de aard van de bedrijfsvragen waar u een antwoord op zoekt. Om zinvolle dataminingactiviteiten te kunnen verrichten, betekent dit ook dat een goed begrip nodig is van het bedrijfsproces dat geanalyseerd wordt. Meestal zult u dus merken dat “bedrijfsanalisten” de meest gekwalificeerde profielen zijn om aan gegevensbewerking te doen, omdat zij degenen zijn die “uw bedrijf en “alle kleine bijzonderheden van uw gegevensbronnen perfect kennen”.

Hoewel bedrijfsanalisten de beste profielen zijn om uw gegevens te laten praten, zijn zij helaas vaak leken op het vlak van codes. Het verwerken van complexe gegevens kan dus al snel een uitdaging worden, die gevolgen zal hebben voor de efficiëntie. De echte uitdaging voor data wranglers is dus vaak gewoon en ruwe code en onbegrijpelijke procedures schrijven om de gegevens in de “juiste vorm” te krijgen. Als u ooit SQL-commando’s van 3 schermen hoog hebt moeten schrijven, weet u wat ik bedoel…

Hopelijk is dit nu iets uit het verleden, aangezien er nu gespecialiseerde data wrangling tools bestaan die de creatie van om het even welke data transformaties toelaten, ongeacht hun complexiteit, zonder één enkele lijn code te schrijven. Eindelijk kunnen we de business-analisten bevrijden van de ketenen van pijnlijke code-intensieve sessies en betere, meer zinvolle analytische resultaten verkrijgen, op een veel eenvoudigere en snellere manier. Uiteindelijk is de nieuwe generatie van data wrangling tools gemaakt om de business-analisten te verlossen van alle pijn en lijden van hun dagelijkse routines in het verleden.

Eigenlijk, met de juiste moderne hulpmiddelen, wordt data wrangling bijna leuk omdat het zo snel en gemakkelijk is dat enig plezier wordt verkregen door het ontdekken van bijna onmiddellijke interessante inzichten in uw gegevens.

Technieken en hulpmiddelen voor gegevensverwerking

Insiders beweren dat de overgrote meerderheid van de analisten het grootste deel van hun werktijd besteden aan het manipuleren van gegevens in plaats van ze werkelijk te analyseren. Historisch gezien waren gegevensverwerkers hoogopgeleide professionals die talen als Python en R beheersten. Het waren dus in de eerste plaats ontwikkelaars. De generatie van “No-Code” ETL’s heeft daar verandering in gebracht.

Data wrangling gebeurt met specifieke technieken en hulpmiddelen. Voorbeelden van generiek te gebruiken hulpmiddelen data wrangling zijn Microsoft Excel spreadsheet VBA code, R code, Python code en Perl code. Ook OpenRefine, een meer geavanceerde versie van Microsoft Excel, wordt gebruikt. In het algemeen zult u, wanneer u R gebruikt, deze bibliotheken gebruiken: JSOnline (nuttig bij parsing), Purrr (hulp bij lijstfunctie-bewerkingen), DPlyr (tool voor gegevensmanipulatie). Tegenwoordig zijn er gespecialiseerde hulpmiddelen die zich bijna volledig richten op gegevensmanipulatie: Anatella (deel van de TIMi Suite), Alteryx, Altair Monarch, enz.

Data wrangling: is het de moeite waard?

Als u zich afvraagt of het data wrangling echt nodig is, beschouw het proces dan als het leggen van de fundering voor een huis. Uw huis zal niet blijven staan zonder stevige fundering. Naar analogie zullen uw analytische “producten” (kpi’s, modellen, enz.) alleen relevant zijn als ze gebaseerd zijn op gegevens die een degelijk voorbereidingsproces hebben doorlopen.

Tijd investeren in data wrangling (verzamelen, opschonen, verrijken, structureren van informatie uit meerdere bronnen), ondersteunt uw besluitvormingsproces.

Hoewel data wrangling niet gemakkelijk is, is het naar mijn mening onmisbaar, omdat het de basis is van al uw activiteiten met betrekking tot data.

Bron: IntoTheMind