L’infrastructure de données doit être efficace et évolutive

Conscientes de l’énorme potentiel des Big Data, de plus en plus d’entreprises cherchent des solutions d’analyse de données susceptibles de satisfaire leurs besoins actuels et futurs. L’efficacité et l’évolutivité revêtent une importance cruciale à cet égard.

Partout dans le monde, des entreprises lancent des initiatives axées sur les données. Pour que leurs analystes parviennent à en extraire de la valeur et des informations précieuses, elles investissent dans de lourdes infrastructures liées au cloud. Avec un espoir : que les résultats obtenus couvrent les factures salées d’Amazon et Azure pour l’exécution de ces calculs titanesques dans de grands centres de données. Un bon choix d’infrastructure hardware est crucial, car il a un impact majeur sur l’efficacité des analystes. Typiquement, les analystes consacrent plus de 80 % de leur temps à de simples tâches de gestion de données (recherche, intégration et data cleaning par exemple). C’est ce qu’on appelle le « 80/20 data science dilemma » (dilemme 80/20 de la science des données). La mise au point d’une solution conviviale pour la transformation rapide des données joue donc un rôle primordial pour le confort, l’efficacité et la productivité de chaque analyste de données au sein d’une entreprise.

Infrastructure Big Data

L’une des erreurs les plus fréquentes en matière d’infrastructure réside dans l’utilisation de Spark, Hadoop et Java – des technologies Big Data généralement associées au cloud. Ce choix est non seulement très onéreux – 99 % des entreprises qui en font usage paient plus d’un demi-million d’euros par an à Amazon ou à Azure –, mais aussi malheureux. Ces technologies sont en effet incapables d’assurer une évolutivité et une accélération adéquate. Une propriété importante pour une bonne infrastructure consiste à offrir davantage de puissance de calcul en cas d’ajout de serveurs. À titre d’exemple : si le nombre de serveurs est doublé, le temps de calcul doit être réduit de moitié (en termes techniques, vous devriez obtenir une accélération gale à 2).

Promesses non tenues

Ce qui a initialement incité les entreprises à adopter Spark, Hadoop ou Java, c’était la promesse d’une accélération presque illimitée via l’ajout de serveurs. On a toutefois récemment découvert que l’accélération maximale pour les tâches classiques de gestion de données n’équivalait généralement qu’à 2, indépendamment du nombre de serveurs – même s’il y en a plusieurs milliers. Cela signifie donc qu’en dépit d’investissements considérables, les analystes de données sont toujours confrontés à des traitements interminables et à des perturbations régulières. À qui la faute ? Aux limitations en matière d’accélération et à l’instabilité de Spark, Hadoop et Java.

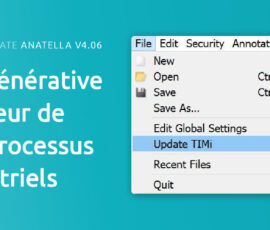

Innovation belge

Même si les technologies Big Data de Spark, Hadoop et Java sont un échec et si les gigantesques investissements consentis dans leur infrastructure sont potentiellement vains, il subsiste une lueur d’espoir pour le monde des Big Data. Et le salut vient même de la Belgique ! TIMi est une solution innovante belge capable d’évoluer, contrairement aux technologies précédentes. En cas d’ajout de serveurs, cette solution atteint aisément des accélérations supérieures à 1 000. C’est bien plus que Spark, Hadoop et Java, plafonnés à un facteur d’accélération de 5 et généralement à peine capables d’allonger la foulée jusqu’à 2. La transition vers TIMi à elle seule entraînera une accélération moyenne de 39. Les frais d’infrastructure seront en outre réduits d’un facteur de 22.2. Par ailleurs, il existe une version communautaire 100 % gratuite. L’autre bonne nouvelle, c’est que ce système est tellement simple qu’avec lui, presque toute personne ayant l’esprit analytique peut rapidement devenir un analyste de données à part entière.

Accroître la sensibilisation

La Belgique est certes un petit pays, de sorte que les volumes de données y sont généralement assez modestes. Proximus, la plus grande société de télécommunications, compte deux millions d’utilisateurs. Ce volume ne requiert pas énormément de puissance de calcul et pourtant, ici aussi, des entreprises déplorent la lenteur de technologies telles que Hadoop, ce qui les contraint à investir des fortunes dans les services d’Amazon et Azure. Et même dans ce cas, leurs analystes de données doivent encore attendre de longues heures des résultats qu’autrement, ils obtiendraient en quelques secondes à peine. Certains en sont déjà conscients, surtout les grandes entreprises disposant de plus gros volumes de données et ayant donc besoin d’une puissance et d’une vitesse de calcul plus élevées. C’est aussi la raison pour laquelle de grands pays, dont certains du tiers-monde, sont actuellement plus avancés que la Belgique en matière d’infrastructure de données. Et c’est particulièrement dommage, surtout quand on sait que la solution à ces défis a été conçue dans notre pays.