Booster la culture analytique au sein de votre entreprise

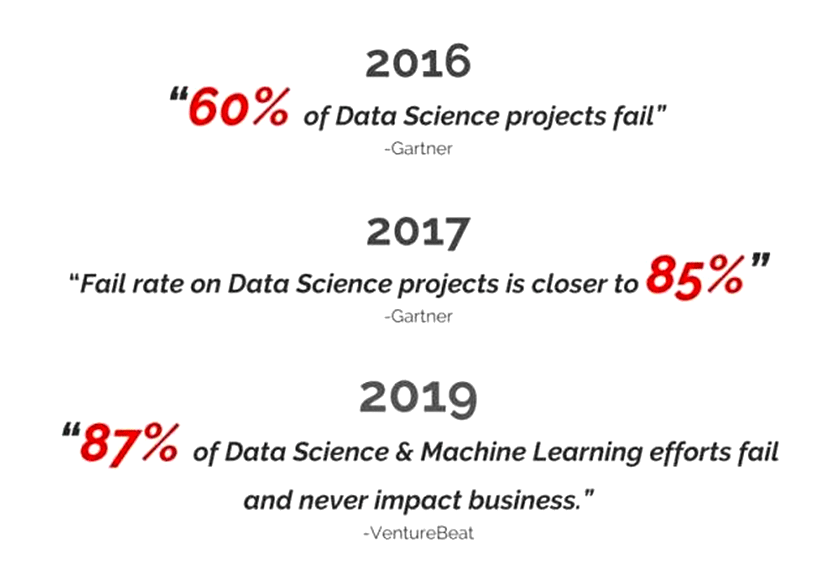

C’est très bien de vouloir booster la Culture Analytique dans son entreprise, mais à quoi ça peut bien servir ? Il ne faut pas perdre de vue que l’objectif final de l’analyse des données c’est : faire plus de profits, sauver des vies ou encore d’autres utilisations plus exotiques. On ne fait pas ça pour s’amuser. On doit arriver à un résultat. Or, il faut savoir qu’une vaste majorité des projets analytiques sont des échecs: Voici quelques statistiques à ce sujet:

Heureusement, il existe un moyen pour garantir le succès de vos initiatives analytiques : la Culture Analytique. Donc, si vous êtes sérieux sur vos initiatives data, si vous voulez garantir que vos efforts et vos investissements en homme et en temps soient rentabilisés, il vous reste une solution : adoptez une Culture Analytique.

La méthodologie traditionnelle

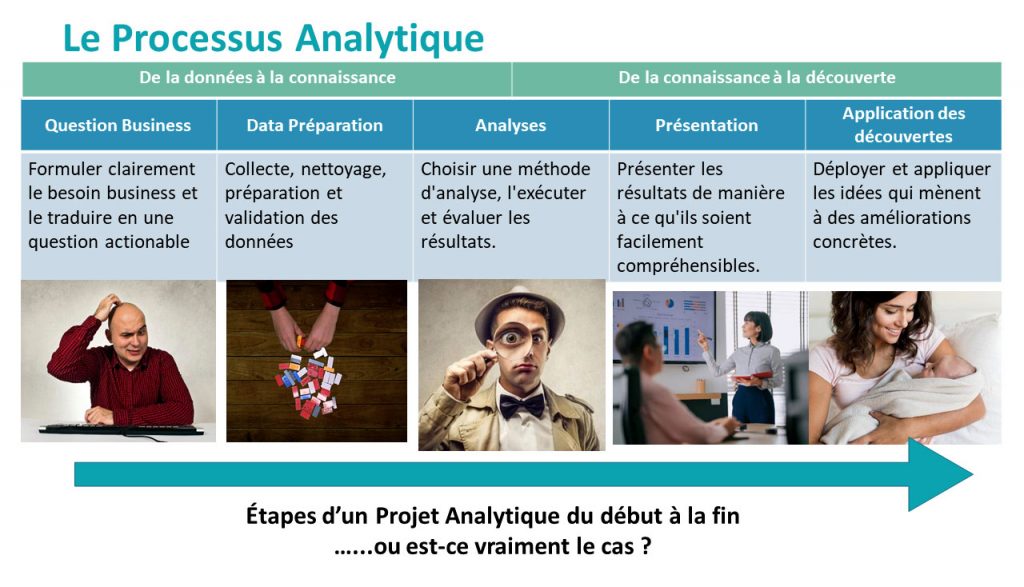

Typiquement, pour résoudre un problème analytique, on suivra une méthodologie en 5 étapes, décrites ci-dessous. Rien de nouveau ici : c’est typique de ce que vous allez voir si vous faites appel à des consultants en analytique.

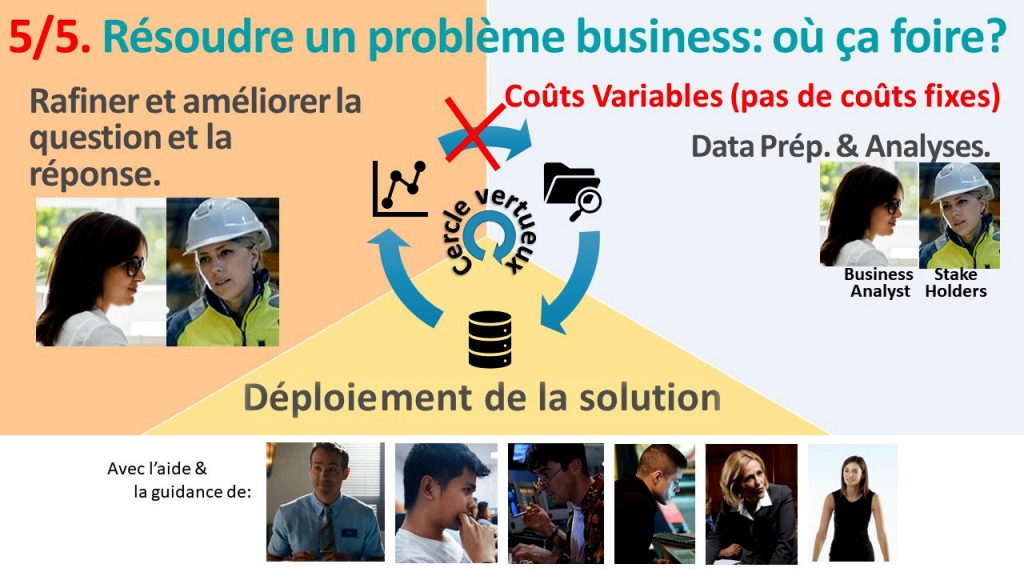

On commence par se poser une question business, ensuite on prépare les données pour pouvoir répondre à cette question. Ensuite on analyse les données. Ensuite on présente les résultats aux personnes concernées: Typiquement le CEO, CMO ou tout intervenant qui est concerné par ces résultats. A ce sujet, il y a un mot en anglais qui représente bien toutes les personnes intéressées dans ces résultats : on les appelle les « Stakeholders ». Ensuite, on déploie les résultats en production pour que ça ait un véritable impact sur le business.

Donc, ça c’est les 5 étapes d’un projet analytique du début à la fin (…mais est-ce vraiment bien comme ça qu’un projet analytique doit se dérouler?). Maintenant on va s’intéresser aux personnes qui réalisent ces 5 étapes.

Les 8 profils qui utilisent les données

Typiquement, il y a 8 profils différents qui utilisent ou consomment les données.

Le CEO dirige la société. Les « IT Guys » font en sorte que les PC fonctionnent bien. Le CDPO s’occupe de garantir la confidentialité des données en accord avec la législation européenne pour le GDPR. Le « data engineer » achète des machines dans le cloud pour optimiser l’infrastructure pour « tenir la charge ». Il y a un point commun à tous ces profils : aucun ne regarde les données.

Ensuite il y a le « StakeHolder ». Dans la littérature, ce profil est parfois aussi appelé « business stakeholder » ou « stakeholder métier ». C’est typiquement lui qui fait tourner la boite : il connaît bien le business. Le « SQL Guy », c’est celui qui s’occupe de stocker les données dans la base de données et pour faire ça, il est régulièrement amené à effectuer des transformations sur les données. Le « Business Analyst » est celui ou celle qui comprends bien les données et qui est capable de créer des KPI pertinents ou des modèles prédictifs pour optimiser le business. Le « data scientist », lui, écris du code complexe, étudie les algorithmes de machine learning et optimise leurs paramètres.

Il y a encore un dernier profil : celui de « data miner ». Dans les années 2000, il n’y avait pas une claire séparation entre ces 3 derniers rôles et, bien souvent, c’était la même personne qui s’occupait de tout faire : c’était le data miner. Mais ils sont de plus en plus rares de nos jours. Un bon conseil : si vous avez la chance d’avoir un data miner dans votre équipe, ne le lâchez pas ! Il vaut de l’or !

Les cinq prérequis pour une culture Analytique en entreprise

La culture analytique est basée sur la simple idée que ceux qui comprennent le problème à résoudre doivent être ceux qui le résolve. Grâce à cette idée, vos initiatives analytiques réussissent et la culture analytique se propage dans votre entreprise.

L’idée est simple mais elle n’est pratiquement jamais mise en œuvre car elle nécessite, pour pouvoir fonctionner, 5 éléments clés, 5 prérequis, qui ne sont pratiquement jamais disponibles dans les sociétés.

- Un outil qui permet une approche itérative

- Un outil en self-service

- Un outil fédérateur.

- Un outil qui facilite l’automatization/industrialization

- Un outil sans coûts variables

1. Un outil qui permet une approche itérative

Mauvaise approche : la méthodologie waterfall

Au début de cet article, nous avons vu la façon traditionnelle de faire des projets analytiques. C’est une approche qui s’appelle l’approche « waterfall » et elle a un gros défaut : elle ne fonctionne pas car elle n’est pas itérative. Cette approche « waterfall » est séduisante mais en analytique elle ne fonctionne pas. C’est d’autant plus dommage que cette approche vous est imposée par plus de 90% des outils utilisés pour faire des projets de data sciences, des projets analytiques. En effet, en data sciences, quand on a développé un bout de code pour répondre à une question business précise, il est commun de revenir sur ce bout de code après quelques mois et de le modifier en profondeur parce qu’on a maintenant une meilleure compréhension du besoin business à résoudre. Pour cela, la data science est un domaine très spécial. Malheureusement, presque tous les développeurs qui tentent d’ajouter des fonctionnalités de data science dans leurs solutions ne comprennent pas ce besoin itératif et, au final, il n’y a presque aucune solution analytique qui permet d’itérer facilement et rapidement.

Et la conséquence se fait directement sentir : malgré une technologie qui a l’air de progresser, le nombre d’échec de projets analytiques ne fait qu’augmenter. Et ce n’est pas étonnant car, malgré la meilleure volonté des personnes impliquées, si on leur impose une méthodologie waterfall foireuse, ça ne risque pas de fonctionner.

La bonne approche : l’approche itérative

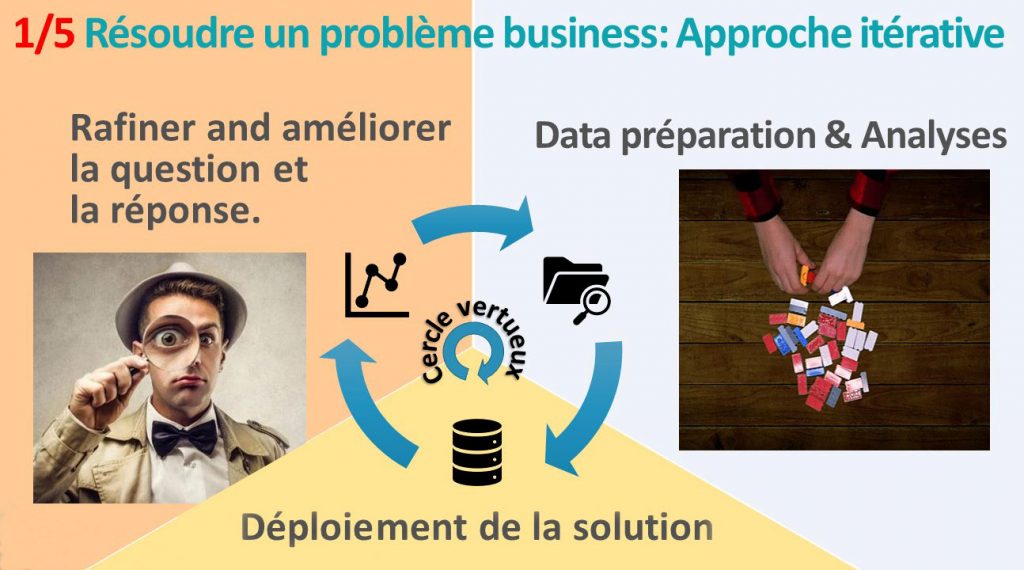

Une première bonne idée, c’est donc d’abandonner la méthodologie « waterfall » et de la remplacer par une approche itérative. Ça veut dire quoi ? Ça veut dire que le processus analytique est désormais représenté comme ceci : avec une boucle qui représente bien l’aspect itératif du processus.

L’approche itérative est le premier des 5 points clés qui permettent à votre entreprise d’adopter une culture analytique. Comment ça marche ? On commence par préparer les données et les analyser. Ensuite, on déploie et on regarde les résultats. Ce qui nous amène ensuite à revoir la façon dont nous avons répondu à la question business et à raffiner cette même question business afin d’améliorer notre approche. Puisque notre question business a changé, il est maintenant nécessaire de changer la data préparation, pour pouvoir répondre à la nouvelle question et on redémarre une nouvelle itération. C’est vraiment un processus itératif et à chaque itération les résultats et les questions s’améliorent pour délivrer de plus en plus de valeur et de connaissance pour votre entreprise. On arrive finalement à un cercle vertueux qui garantit une amélioration continue de tous les processus au sein de votre entreprise.

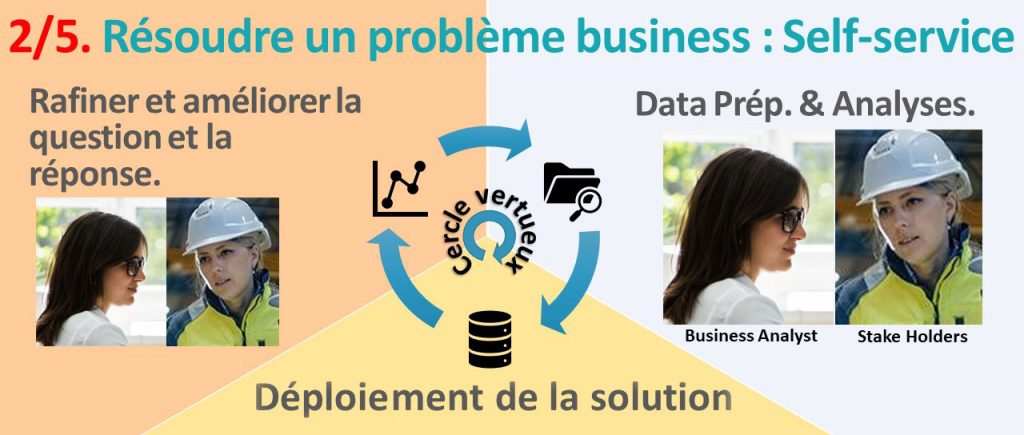

2. Un outil en self-service

Bien évidemment, ce qu’on aimerait c’est de faire le plus d’itération possible en le moins de temps possible. Alors, qu’est ce qui bloque ? Qu’est-ce qui prends du temps dans ce cercle vertueux ?

Ce qui bloque, c’est la data préparation. Elle prend 80% à 90% du temps de travail. Et ça, c’est un fait connu : tous ceux qui ont déjà fait un peu de data science le savent. Voici trois journaux qui expliquent que la data préparation prend 80% à 90% du temps de travail:

- Par exemple:Le magazine Forbes a fait une enquête sur le sujet et ils arrivent aux mêmes conclusions : 80% du temps de travail d’un projet analytique est consacré à la data préparation.

- Le magazine New York Times dit exactement la même chose : la préparation des données occupe 80% du temps de travail d’un projet analytique.

- Et le magazine InfoWorld répète la même chose : le travail de préparation des données occupe 80% du temps de travail d’un projet analytique.

Donc la data preparation, c’est le vrai nœud du problème. Elle consomme 80% du temps de travail et elle est cruciale : Sans une bonne data préparation, toute analyse ultérieure est vouée à l’échec.

Dans un projet analytique, c’est très bien d’utiliser des algorithmes de machines learning ultra compliqués et supers performants, comme TIMi Modeler, mais ce n’est pas là où est le nœud du problème : la partie cruciale quand on fait de l’analytique, c’est de s’assurer que la data préparation est bien faite.

Qui va faire la data prep ?

Si on veut qu’elle soit bien faite, il reste encore à répondre à la question : Qui va faire la data prep ? C’est important de répondre correctement à cette question parce que la data prep est le vrai nœud du problème. De plus, la data préparation est dépendante de la question business qu’on se pose. En d’autres termes, des questions business différentes donne lieu à des data préparations différentes. Or, cette question business elle change au cours du temps : à chaque itération, elle est affinée parce qu’on comprend mieux le problème à résoudre.

Quand on dit “on”. C’est qui ces personnes qui comprennent de mieux en mieux le problème à résoudre ? Typiquement, ce seront les business analystes ou les stakeholders. Mais bien souvent, ce sera juste les stakeholders car ce sont les seuls à comprendre toutes les petites subtilités métiers nécessaires à affiner l’analyse. Ce sont les seuls qui ont plus de 20 années d’expérience derrière eux pour voir si les résultats sont cohérents.

Maintenant, il y a aussi des situations exceptionnelles où on a des data scientistes qui sont vraiment dévoués à l’entreprise et, dans ce cas, ils font l’effort d’apprendre toutes les petites subtilités du métier de leur client. …Mais ce type d’employé est de plus en plus rare, surtout dans un contexte où les data scientistes font du « saute-mouton » d’une société à l’autre tous les 3 mois.

Bon, évidemment, cela ne veut pas dire qu’il faut forcer les « stakeholder » à écrire du code. Ce n’est pas leur job et les forcer à coder dans des langages barbares c’est juste une perte de temps pour tout le monde. Ce n’est pas là où ils ont le plus de valeur pour l’entreprise.

« Ceux qui comprennent le problème à résoudre

Où, à tout le moins, ils doivent faire partie de la solution.

doivent être ceux qui le résolve »

Cela veut dire que les stakeholders doivent faire partie intégrante du processus de résolution du problème analytique. Ils doivent pouvoir intervenir pour « corriger le tir » à chaque itération, grâce à leur expérience métier. En fait, on pourrait résumer en une seule et unique phrase tous les éléments exposés jusqu’à présent et qui permettent d’avoir un projet analytique qui est un succès. Cette phrase est simplement : « Ceux qui comprennent le problème à résoudre doivent être ceux qui le résolve. » Cette phrase résume bien tout ce qu’on a dit jusqu’à maintenant et on ne peut vraiment pas en critiquer le principe.

On peut aller encore plus loin et dire : « Ceux qui comprennent le problème à résoudre doivent être ceux qui font la data prep. ». …parce que, faire une bonne data prep, c’est pratiquement équivalent à résoudre le problème analytique parce que le reste du processus est pratiquement négligeable.

Cette règle de « Ceux qui comprennent le problème à résoudre doivent être ceux qui le résolve. », elle parait évidente mais, en pratique, elle est rarement appliquée car, pour faire une bonne data prep, il faut que ça soit les stakeholders et les business analystes qui y passent du temps.

…et pour ça, il faut un outil de data préparation sans code, aussi appelé « outil en self-service ». L’aspect self-service de l’outil de data préparation a l’air un peu anecdotique comme ça mais, en réalité, il est crucial pour permettre aux stakeholders et aux business analystes de faire la data prep ensemble. Le « Self-service » est le 2ième point clé qui permet à une culture analytique de se propager dans votre entreprise.

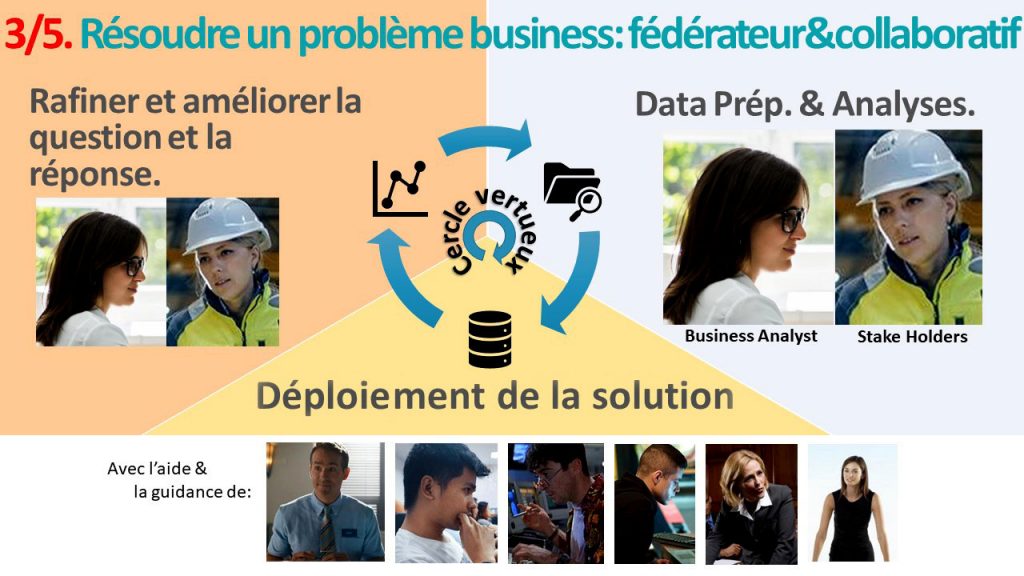

3. Un outil fédérateur

Un outil de data préparation en self-service c’est bien, mais ce n’est pas encore suffisant. En effet, les Business Analystes et les Stake Holders vont devoir collaborer avec les 6 autres profils pour arriver à une analyse pertinente des données. Il faut qu’ils puissent facilement dialoguer avec le SQL Guy, le data scientiste, le data engineer, le IT Guy, le CDPO et le CEO. Donc, en résumé, il faut un outil fédérateur qui permet à tous les profils de collaborer autour du même objectif : résoudre le problème business en cours. L’aspect fédérateur est le 3ième point clé qui permet à une culture analytique de se propager dans votre entreprise.

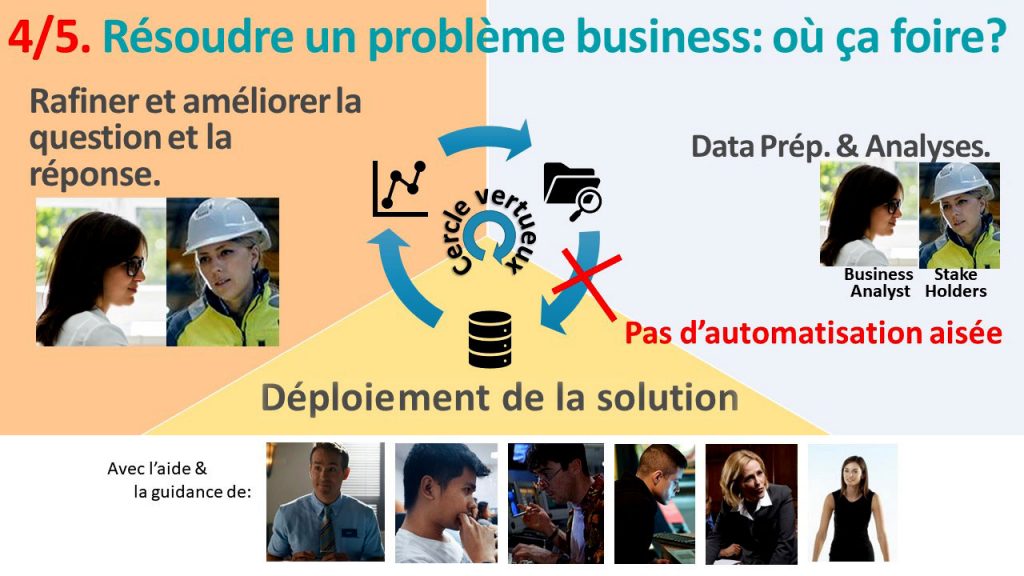

4. Un outil qui facilite l’automatisation

Sur l’infographie ci-dessus on peut lire que « 87% des projets analytiques n’ont jamais d’impact sur le business. » Ça veut dire quoi ? ça veut dire que les projets analytiquesrestent à l’état embryonnaire, sans être mis en production et donc sans impacter le business. Et c’est effectivement ce qu’on constate aussi quand on arrive dans une société qui démarre dans le domaine de l’analytique : il y a plein d’initiatives de tous les côtés, plein de personnes super motivées mais pratiquement rien qui rentre en production.

Donc, un 4ième point clé pour la réussite de vos initiatives analytiques est de pouvoir facilement mettre en production vos découvertes.

Il y a plein de raisons qui peuvent compromettre la mise en production. En voici 3 communes:

- l’instabilité des outils utilisés.

C’est particulièrment vrai pour les outils développés en java : ceux-là sont particulièrement instables. - Un prix variable qui devient rapidement prohibitif.

Bien souvent, on fait un prototype sur un petit sous-ensemble de données et, ensuite, quand on passe en production, il faut traiter l’ensemble des données de toute la boite, et là, ça devient impossible pour des raisons de coûts : ça devient juste trop cher. C’est le genre de truc qui arrive tout le temps quand on travaille dans le cloud. - Un outil « in-memory ».

On a utilisé un outil qui ne marche bien que sur une petite volumétrie de données et qui plante complètement sur une grosse volumétrie. Ce sont souvent des outils de types « in-memory » qui sont limités en volumétrie et qui finissent par crasher en continu.

5. Un outil sans coûts variables

Le 5ième et dernier point clé pour la réussite de vos initiatives analytiques et la propagation de la culture analytique dans votre entreprise est l’absence de coûts variables.

Vous imaginez bien que, si à chaque itération de ce cercle vertueux, il faut payer un demi millions d’euros en frais cloud à Amazon, alors on ne risque pas de faire beaucoup d’itérations ! 😉

Un autre effet pervers des frais variables et de pénaliser et de réprimander les data scientistes les plus motivés de votre équipe. En effet, un jeune data scientiste enthousiaste qui fait un usage intensitif de votre infrastructure pour explorer au mieux vos données et en retirer toute la valeur coutera beaucoup plus cher que ses collègues, moins motivés, qui passent leur temps à boire du café à la machine à café. Et, à la fin du mois, le data scientiste motivé est réprimandé par le directeur financier à cause des importants frais cloud qu’il occasionne, surtout en comparaison à ses collègues. En résumé, un outil cloud de data science qui fonctionne en « coût variable » a pour effet de pénaliser, réprimander, décourager et finalement empêcher vos meilleurs éléments de travailler.

Vraiment, les frais variables, ça bloque complètement toute chance de succès de vos initiatives analytiques.

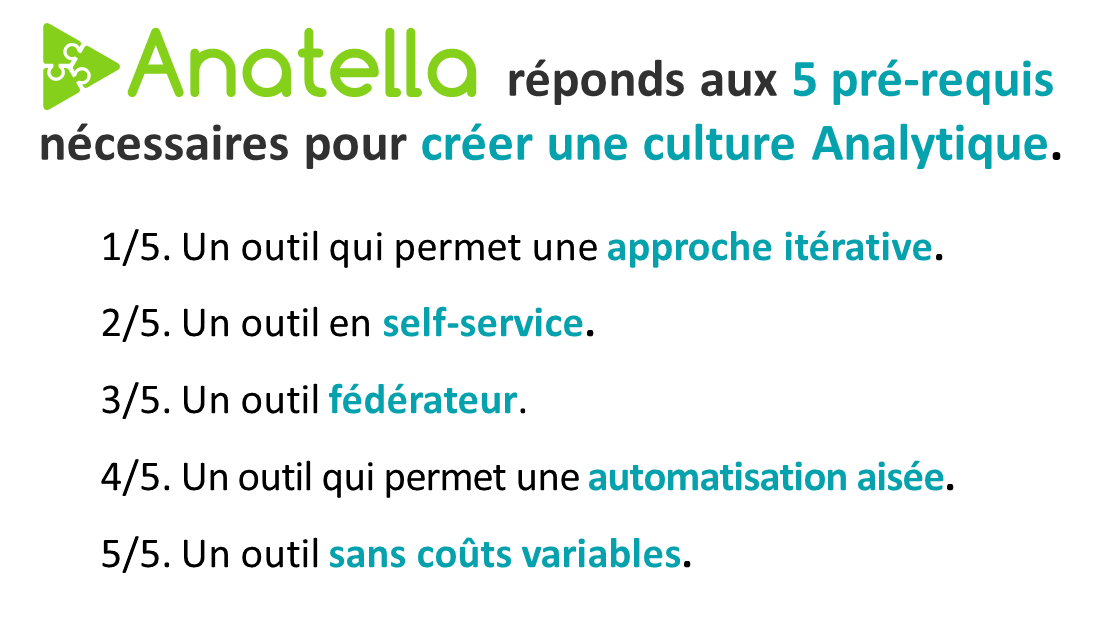

Voila ! Nous avons vu ensemble les 5 points clés nécessaires pour créer, ou booster, la culture Analytique dans votre entreprise. Maintenant que nous avons connaissance de ces 5 points clés, il reste encore à voir comment faire pour les obtenir.

La solution pour créer une culture analytique : Anatella

Bizarrement, il n’existe actuellement qu’une seule solution de data science qui réponde à ces 5 prérequis.

Et puis vous vous étonnez que les ¾ des projets analytiques foirent ? 😅

Cette solution, c’est Anatella. Anatella est la seule solution qui réponde aux 5 prérequis nécessaires pour créer une culture Analytique dans votre entreprise. Alors, c’est bien de le dire mais c’est encore mieux de le démontrer. Donc voici rapidement quelques indices qui vous permettront de vous faire une idée. Est-ce que Anatella est vraiment la seule solution qui réponde aux 5 prérequis pour avoir une culture Analytique ?

Anatella permet à vos experts métiers de travailler de façon itérative et de faire facilement faire plein d’itérations. En fait, Anatella possède de nombreuses autres fonctionnalités nécessaires pour d’adopter une approche itérative quand on travaille sur des projets analytiques. Si vous souhaitez en savoir plus, nous avons fait 2 vidéos assez techniques sur le sujet : ce sont en fait les vidéos numéro 5 et numéro 6 du cycle de formation de base pour apprendre à utiliser Anatella.

Dans ces même vidéos, vous pouvez aussi voir qu’on peut utiliser Anatella entièrement sans taper une ligne de code, entièrement en self-service.

Quant à l’aspect fédérateur, outre une interface graphique jolie et conviviale, l’outil doit offrir un système basé sur des couches d’abstraction. En plus, l’outil ne doit pas être un simple générateur de code parce que ça impose des limitations qui empêchent aussi l’aspect fédérateur. Si ça vous intéresse, nous avons une page qui couvre le sujet.

Quant à l’automatisation, c’est quelque chose d’important mais, au final, ce n’est pas très compliqué à réaliser quand on a déjà un outil comme Anatella. Une bonne intégration avec un outil de planification (un « scheduler » en anglais) fait l’affaire. Nous avons choisi Jenkins comme scheduler parce que c’est un logiciel facilement extensible, et qui possède déjà des centaines de plugins pour gérer absolument toutes les situations de scheduling possible.

Vous pouvez découvrir ici et ici des vidéos qui montrent l’intégration entre Anatella et Jenkins. En résumé, en seulement 4 clics de souris, vous mettez un processus Anatella en production dans Jenkins. L’automatisation, avec Anatella, c’est vraiment super facile !

Quant aux coûts d’opération d’un système basé sur Anatella, ils sont très réduits, principalement parce qu’une infrastructure hardware très réduite est capable d’absorber pratiquement n’importe quelle charge de calcul et n’importe quelle volumétrie. Du coup, vous pouvez vous attendre à avoir des frais d’infrastructure hardware pratiquement constants, sans partie variable. Et les frais de licence de TIMi et Anatella sont eux aussi constants et indépendants de la volumétrie traitée. Donc, vous pouvez être tranquille de ce côté-là : Pas de coûts variables !

La solution la plus rapide du marché

En plus des 5 prérequis que nous venons de voir, Anatella est aussi la solution de data préparation la plus rapide et la plus scalable du marché. Techniquement, Anatella est plus de 20 années en avance, par rapport à absolument tous ses concurrents, si jamais les concurrents arrivent à la rattraper, ce qui est quand même peu probable.

Donc, si vous êtes sérieux sur vos initiatives data, si vous voulez garantir que vos efforts et vos investissements en homme et en temps soient rentabilisés : il vous reste une solution : Anatella. Les témoignages que vous trouverez sur G2 démontrent que tout cela est bien réel. Pour vous dire, sur G2, on a le plus haut taux de satisfaction de toutes les solutions de Data sciences.

Voir vos projets analytiques aboutir

Chez TIMi, nous sommes animés par une valeur en particulier qui est l’éthique. Et, dans cette optique, avant tout profit, ce que nous désirons c’est voir vos projets analytiques aboutir.

Comme, de plus, chaque société aborde l’analytique de manière différente, votre période d’essai gratuite de TIMi est flexible, pour s’adapter à votre façon de travailler. Généralement, 2 mois sont suffisant pour comprendre tout ce qu’un outil analytique génialissime comme TIMi peut vous offrir. En plus, vous bénéficiez tout du long d’un accompagnement sur mesure, et ce jusqu’à ce vous ayez pu vous ayez pu démontrer l’intérêt de l’analytique, de la culture analytique et de TIMi dans votre entreprise avec votre premier succès.

Il ne vous reste plus qu’à faire le pas et à rejoindre les centaines de sociétés dynamiques qui innovent à travers l’analytique grâce à TIMi !

Et pour faire le pas, c’est simple, vous cliquez sur « Télécharger TIMi » et ensuite vous cliquez sur le gros bouton turquoise au milieu de la page. Il y a un wizard automatique qui va installer TIMi et, après quelques minutes, vous pourrez commencer à jouer avec vos données.